一、Flow 2.0 简介 1.1 Flow 2.0 的产生 Azkaban 目前同时支持 Flow 1.0 和 Flow2.0 ,但是官方文档上更推荐使用Flow 2.0,因为Flow 1.0会在将来的版本被移除。Flow 2.0的主要设计思想是提供1.0所没有的流级定义。用户可以将属于给定流的所有job / properties文件合并到单个流定义文件中,其内容采用YAML语法进行定义,同时还支持在流中再定义流,称为为嵌入流或子流。

1.2 基本结构 项目zip将包含多个流YAML文件,一个项目YAML文件以及可选库和源代码。Flow YAML文件的基本结构如下:

每个Flow都在单个YAML文件中定义;

流文件以流名称命名,如:my-flow-name.flow;

包含DAG中的所有节点;

每个节点可以是作业或流程;

每个节点 可以拥有 name, type, config, dependsOn 和 nodes sections等属性;

通过列出dependsOn列表中的父节点来指定节点依赖性;

包含与流相关的其他配置;

当前properties文件中流的所有常见属性都将迁移到每个流YAML文件中的config部分。

官方提供了一个比较完善的配置样例,如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 config: user.to.proxy: azktest param.hadoopOutData: /tmp/wordcounthadoopout param.inData: /tmp/wordcountpigin param.outData: /tmp/wordcountpigout nodes: - name: AZTest type: noop dependsOn: - hadoopWC1 - NoOpTest1 - hive2 - java1 - jobCommand2 - name: pigWordCount1 type: pig config: pig.script: src/main/pig/wordCountText.pig - name: hadoopWC1 type: hadoopJava dependsOn: - pigWordCount1 config: classpath: ./* force.output.overwrite: true input.path: ${param.inData} job.class: com.linkedin.wordcount.WordCount main.args: ${param.inData} ${param.hadoopOutData} output.path: ${param.hadoopOutData} - name: hive1 type: hive config: hive.script: src/main/hive/showdb.q - name: NoOpTest1 type: noop - name: hive2 type: hive dependsOn: - hive1 config: hive.script: src/main/hive/showTables.sql - name: java1 type: javaprocess config: Xms: 96M java.class: com.linkedin.foo.HelloJavaProcessJob - name: jobCommand1 type: command config: command: echo "hello world from job_command_1" - name: jobCommand2 type: command dependsOn: - jobCommand1 config: command: echo "hello world from job_command_2"

二、YAML语法 想要使用 Flow 2.0 进行工作流的配置,首先需要了解YAML 。YAML 是一种简洁的非标记语言,有着严格的格式要求的,如果你的格式配置失败,上传到Azkaban的时候就会抛出解析异常。

2.1 基本规则

大小写敏感 ;

使用缩进表示层级关系 ;

缩进长度没有限制,只要元素对齐就表示这些元素属于一个层级;

使用#表示注释 ;

字符串默认不用加单双引号,但单引号和双引号都可以使用,双引号表示不需要对特殊字符进行转义;

YAML中提供了多种常量结构,包括:整数,浮点数,字符串,NULL,日期,布尔,时间。

2.2 对象的写法 2.3 map的写法 1 2 3 4 5 6 7 key: key1: value1 key2: value2 {key1: value1 , key2: value2 }

2.3 数组的写法 2.5 单双引号 支持单引号和双引号,但双引号不会对特殊字符进行转义:

1 2 3 4 5 s1: '内容\n字符串' s2: "内容\n字符串" 转换后: { s1: '内容\\n字符串' , s2: '内容\n字符串' }

2.6 特殊符号 一个YAML文件中可以包括多个文档,使用---进行分割。

2.7 配置引用 Flow 2.0 建议将公共参数定义在config下,并通过${}进行引用。

三、简单任务调度 3.1 任务配置 新建flow配置文件:

1 2 3 4 5 nodes: - name: jobA type: command config: command: echo "Hello Azkaban Flow 2.0."

在当前的版本中,Azkaban同时支持 Flow 1.0 和 Flow 2.0,如果你希望以2.0的方式运行,则需要新建一个project文件,指明是使用的是Flow 2.0:

1 azkaban-flow-version: 2.0

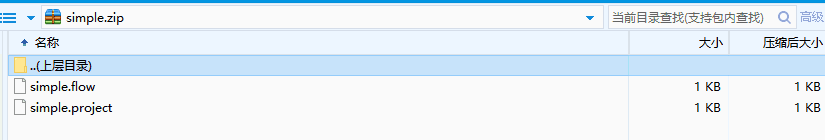

3.2 打包上传

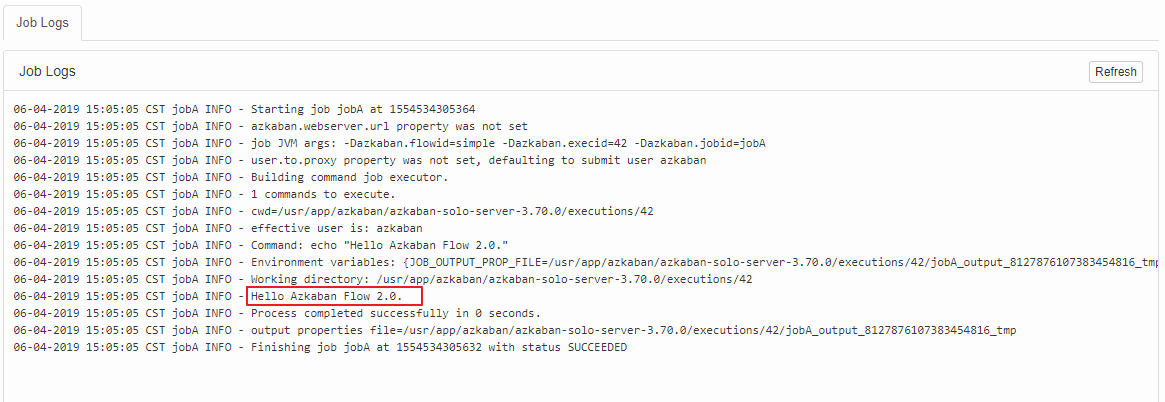

3.3 执行结果 由于在1.0 版本中已经介绍过Web UI的使用,这里就不再赘述。对于1.0和2.0版本,只有配置方式有所不同,其他上传执行的方式都是相同的。执行结果如下:

四、多任务调度 和1.0给出的案例一样,这里假设我们有五个任务(jobA——jobE), D 任务需要在A,B,C任务执行完成后才能执行,而 E 任务则需要在 D 任务执行完成后才能执行,相关配置文件应如下。可以看到在1.0中我们需要分别定义五个配置文件,而在2.0中我们只需要一个配置文件即可完成配置。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 nodes: - name: jobE type: command config: command: echo "This is job E" dependsOn: - jobD - name: jobD type: command config: command: echo "This is job D" dependsOn: - jobA - jobB - jobC - name: jobA type: command config: command: echo "This is job A" - name: jobB type: command config: command: echo "This is job B" - name: jobC type: command config: command: echo "This is job C"

五、内嵌流 Flow2.0 支持在一个Flow中定义另一个Flow,称为内嵌流或者子流。这里给出一个内嵌流的示例,其Flow配置如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 nodes: - name: jobC type: command config: command: echo "This is job C" dependsOn: - embedded_flow - name: embedded_flow type: flow config: prop: value nodes: - name: jobB type: command config: command: echo "This is job B" dependsOn: - jobA - name: jobA type: command config: command: echo "This is job A"

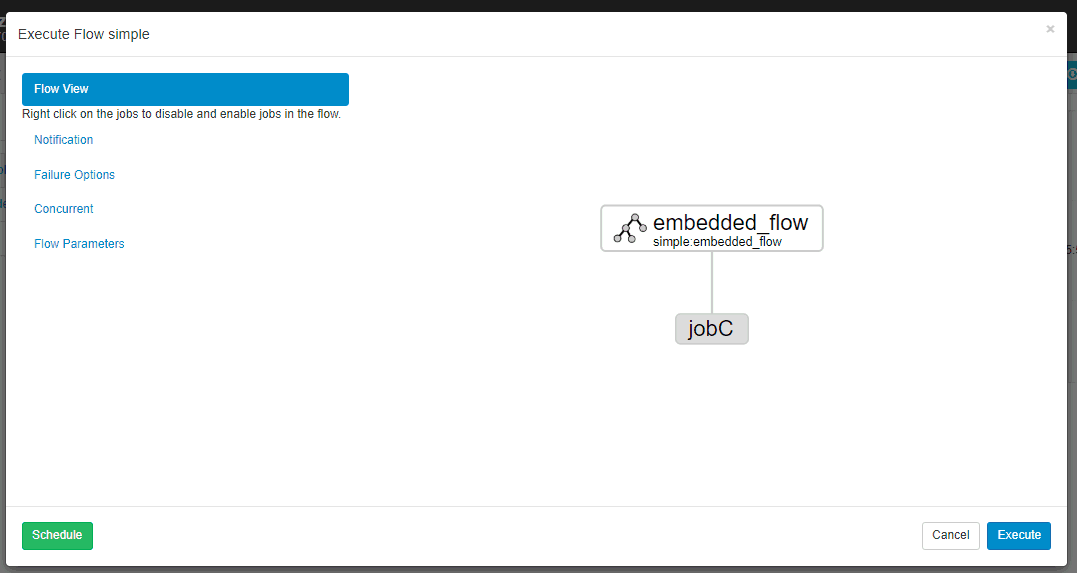

内嵌流的DAG图如下:

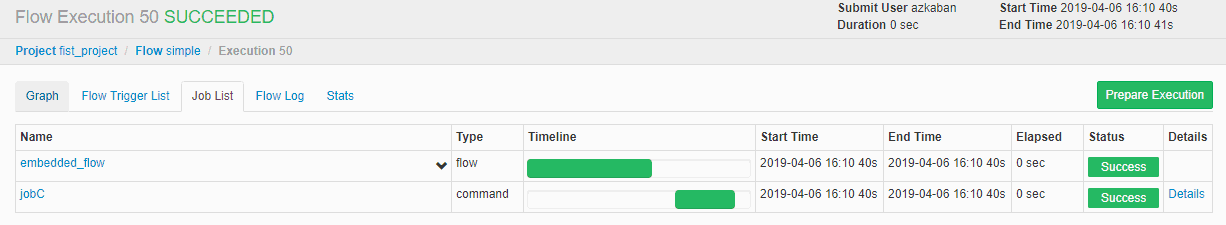

执行情况如下:

参考资料

Azkaban Flow 2.0 Design Getting started with Azkaban Flow 2.0